Article d'Edith Coron - Coach ICF PCC

En consacrant son Forum 2018 à l’Intelligence Artificielle, conçu et animé par l’antenne ICF Paris Ile-de-France, ICF France avait trois ambitions :

- Pour chacun d’entre nous, citoyens de notre monde contemporain, entrer de plein pied dans le débat sur la place grandissante qu‘occupe l’Intelligence Artificielle.

- Professionnels de l’accompagnement, coachs et spécialistes des ressources humaines en entreprises, nous demander comment relier Intelligence Emotionnelle et Intelligence Artificielle, comment préserver l’humain dans les organisations ?

- Nous interroger sur l‘impact de l’Intelligence Artificielle sur nos métiers.

- Les menace-t-elle ?

- Remet-t-elle, à l’inverse, nos métiers au cœur de l’équation IA/ IE ?

- Quel est, et quel sera notre rôle dans cette combinatoire ?

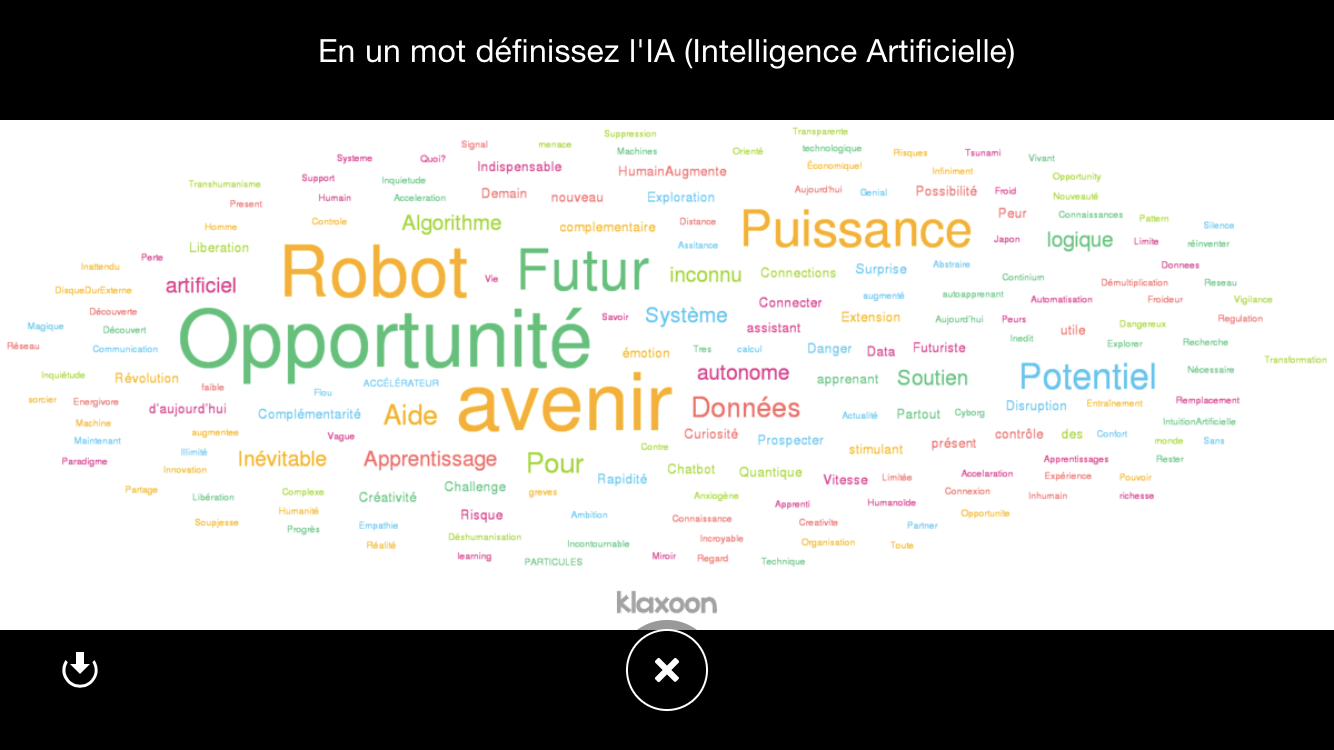

Un baromètre initial auprès des participants, par un nuage de mots sur Klaxoon, révèle un mélange de crainte et de curiosité, à l’égard de l’IA. Le philosophe Jean Michel Besnier[1] qui ouvre la journée, fait écho à cette ambivalence. Il rappelle que les inquiétudes qui entourent l’Intelligence Artificielle remontent à sa création, à la fin des années quarante, avec un de ses pères, le cybernéticien Norbert Wiener qui lui prédisait « un impact comparable à celui de la bombe atomique ». Plus près de nous, l’astro-physicien Stephen Hawking, récemment décédé, dont la maladie lui imposait d‘être dépendant des machines, avait lancé un appel : « l’IA risque de tuer l’espèce humaine », mettait-il en garde.

Prise de conscience salutaire

Pour Jean Michel Besnier les préoccupations actuelles sur l’IA sont « une prise de conscience salutaire ». La technique, dit-il, n’est plus simplement l’univers des outils mais « un monde qui nous englobe et qui fait culture sur nous ». L’IA est le nom donné aujourd’hui à « cette maitrise du réel qui passe par des procédures de conversions numériques qui permettent la description, l’exploitation et la transformation de la réalité ».

Les limites de l'Intelligence Artificielle

Toutefois pour Jean Michel Besnier, l’IA trouverait « sa limite dans son incapacité à gérer le caractère informel voire parfois irrationnel des comportements humains qui sont pourtant ajustés à des situations sans le vouloir expressément, sans le préméditer, sans même l’anticiper ». Il met en garde contre ceux qui veulent en finir « avec l’informel de la décision humaine », et donner une définition réductrice de l’intelligence humaine qui n’aurait « plus rien à voir avec la représentation d’une vie intérieure ou d’une subjectivité qui serait capable de délibérer avant de prendre les bonnes décisions ».

Où allons-nous chercher nos outils ?

Nous interpellant directement, Jean Michel Besnier lance : « Les professionnels de la relation que vous êtes, n’avez-vous pas à faire avec cette opposition entre les investigateurs du psychisme et les spécialistes du cerveau. Où allez-vous aller chercher vos outils ? Dans une démarche de conviction passant par la relation dialoguée ou dans une stratégie construite à partir des modèles ».

Résister à l'Intelligence Artificielle

Il estime que « la prétention de l’IA à imiter l’humain se construit sur la base d’une réduction de la complexité ». Il souligne un paradoxe : en développant l’IA nous nourrissons notre propre vulnérabilité, en choisissant la simplification, nous appauvrissons l’humain. Il prône la résistance à l’IA pour trois raisons :

- Le langage n’est pas un système de signaux mais un système de signes qui « permet de distancier la réalité ».

- Notre intelligence particulière nous permet « d’interrompre les automatismes de l’instinct ».

- Nous sommes capables de gratuité et « ceci définit l’humain, du moins dans la culture humaniste ».

[1] Jean-Michel Besnier : Directeur du laboratoire de recherche du CNRS, « Santé connectée et humain augmenté », Professeur de philosophie à l’Université de Paris IV Sorbonne-chaire de philosophie des technologies d’information et de communication. Auteur de nombreux ouvrages dont trois sont plus particulièrement liés à notre sujet :

- « L’homme simplifié » qui traite de la façon dont la technologie transforme nos comportements et nos manières de penser.

- « Les robots font- ils l’amour ? » avec Laurent Alexandre qui aborde 12 grandes questions autour de l’Intelligence Artificielle et plus largement des Nanotechnologies, Biotechnologies, Informatique et sciences cognitives, connues sous l’acronyme NBIC.

- « Un cerveau très prometteur » qui est une discussion avec Francis Brunelle, professeur de Radiologie, à l Hopital Necker-Enfants-Malades,et Florence Gazeau une collègue coach et consultante en développement organisationnel.

Table ronde 1 : " Quelles perspectives offre l'Intelligence Artificielle au service de l'Intelligence Emotionnelle en entreprise ? "

Les intervenants :

Aude Vinzerich, directrice du Pôle Intelligence Artificielle d’EDF crée en avril 2017.

Bernard Georges, responsable de la Prospective Stratégique au sein de la Direction des Ressources et de l’Innovation du Groupe Société Générale.

Pascale Maginot, directrice des Ressources Humaines Direction Nord d’Orange.

Isabelle Galy, membre fondatrice du Hub France Intelligence Artificielle. Professeur du droit des technologies innovantes à la Sorbonne.

Edith Coron, coach PCC-ICF, animation

Un premier tour de table porte sur les définitions de d’IA. Aude Vinzerich offre une définition « pragmatique » en considérant comme étant de l’IA les outils qui permettent de simuler une partie de l’humain sur quatre domaines principaux : la perception, le raisonnement, la compréhension du langage naturel, l’apprentissage.

Pascale Maginot ajoute : les Big Datas, la robotisation, l’automatisation derrière l’IA.

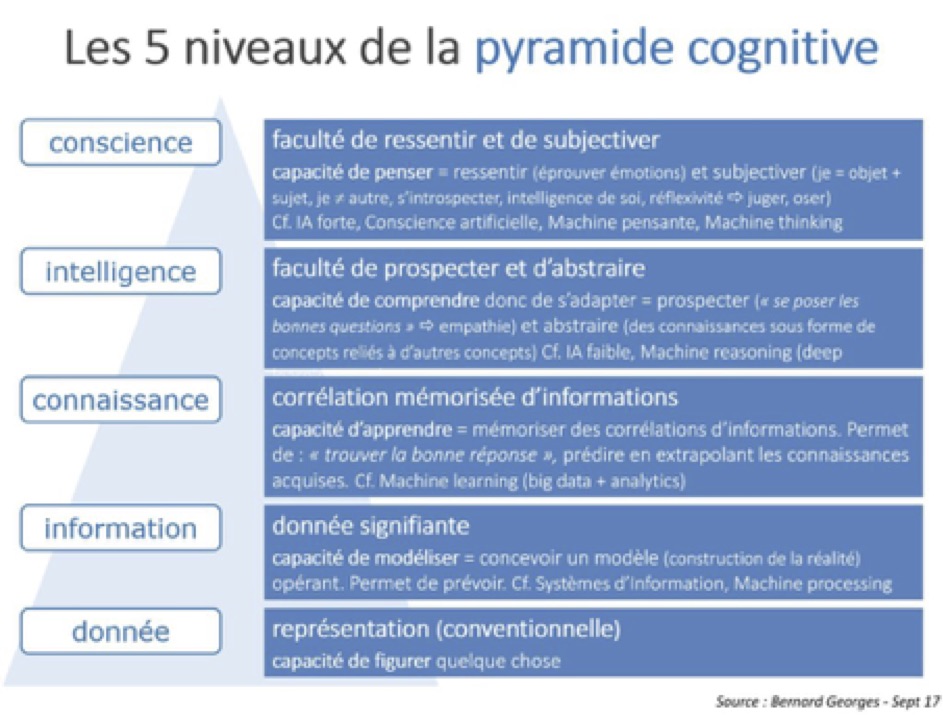

Bernard Georges présente une pyramide cognitive qu’il a élaborée :

La juriste Isabelle Galy est formelle :« En aucun cas nous avons une définition globale de l’IA ». Elle rappelle que le cadre juridique actuel porte seulement sur des technologies qui composent des aspects de l’IA (droit des algorithmes, droit des bases de données, droit d’auteur appliqué à la société de l’information).

La réalité de l'Intelligence Artificielle

Interrogés sur la réalité de l’IA aujourd’hui, dans leurs entreprises ou comme objet d’étude, les intervenants font un rapide état des lieux.

Dans le domaine RH, Orange développe, dit Pascale Maginot, « une expérience salarié augmentée » par lequel, dans le domaine RH « l’IA peut aider les RH, les managers, à offrir un meilleur service aux salariés », avec en particulier des bases de profils stratégiques de salariés qui se sont identifiés et des assessments. Actuellement analysés par les RH puis étudiés avec un coach, ils pourraient, à terme, être remplacés par un coach virtuel ou par un RH avec un assistant virtuel.

Aude Vinzerich explique avoir lancé en moins d’un an douze assistants virtuels (chat bots), pour les métiers du groupe en charge du support. « Cela permet de décharger les salariés sur tout type de domaine, RH, IT, nucléaire ». Elle identifie ainsi le re-routage de mails, l’analyse de données textuelles de rapports par un réseau de neurones qui sélectionne les plus pertinents sur un sujet et qui sont ensuite traités par les ingénieurs. L’IA intervient aussi pour le traitement de l’image des niveaux d’eau des barrages, l’auscultation par des robots des tours de réfrigérantes des centrales nucléaires.

Les banques ont été pionnières dans l’utilisation de l’IA. A la Société Générale, Bernard Georges rappelle qu’elle est appliquée « dans la banque de détail avec les assistants bancaires et dans la banque de finance et d ‘investissement avec les « robots advisors ». Il précise qu’aujourd’hui les entreprises font du « push product » grâce aux Big Datas, « elles devront à l’avenir rendre leurs systèmes empathiques, c’est à dire capables de se poser les bonnes questions du point de vue des clients, faire du « pull client ».

Interrogations

L’IA suscite de nombreuses interrogations. Isabelle Galy demande ainsi : « Qui va prendre la décision ? Notre culture technologique, nous fait croire qu’il y a une neutralité de la technologie qui serait beaucoup plus objective que nous le sommes puisqu’elle est basée sur des données qui seraient elles-mêmes objectives. Or, les données peuvent être tronquées, biaisées, et surtout, elles sont sujettes à interprétation ». Elle s’interroge aussi sur la confiance que l’on peut avoir dans l’intelligence artificielle.

Bernard Georges insiste sur « la dimension culturelle », sur l’importance « de comprendre de quoi on parle ». Il a ainsi engagé une vaste campagne de sensibilisation auprès de 10 000 personnes pour associer les collaborateurs à la réflexion sur l’IA et ses conséquences.

« Il faut aborder, dit-il, la question du travail et des nouveaux modèles de société induits par l’IA ». Il en appelle « à l’humanisme, aux valeurs de la raison, si nous voulons, en tant que collectivité, conserver nos points de repères ».

Pour Pascale Maginot, l’avenir de l’IA pose des questions « sur l’utilisation qu‘on en fera. Dépendra-t-on du choix fait par les algorithmes ou va-t-on garder son libre arbitre ? »

Elle souligne le risque de discrimination par les outils d’IA et de la réduction de la diversité.

Aude Vinzerich met en avant « l’impact humain ». L’IA va profondément transformer certains emplois voire même en supprimer certains. Elle évoque l’importance des plans de reconversion, de l’adhésion des employés et du cadrage éthique de l’utilisation de l’IA. Par exemple, si le choix fait par un réseau de neurones pour sélectionner des candidats à un poste n’est pas explicable, « on va favoriser un outil moins performant mais pour lequel on aura toute l’explicabilité du raisonnement de la machine ».

Les impacts de l'Intelligence Artificielle sur les métiers de l'accompagnement

Pour Bernard Georges, « on est face à une co-révolution cognitive : une révolution cognitive au niveau des machines, et une révolution cognitive sur le plan humain. Il va falloir trouver des capacités d’adaptation pour faire face à cette accélération du numérique et des machines ».

Il faut, précise-t-il, renforcer les compétences qui sont spécifiquement humaines : « développer les capacités d’empathie cognitive, émotionnelle, aller plus vers le savoir-être plus que le savoir-faire. Pour les responsables il faudra incarner ce changement. Prendre conscience que dans ce monde globalisé où les questions de solidarité deviennent de plus en plus sensibles : c’est la politique du « care », comment on prend soin de soi, des autres, de l’environnement. Prendre soin de soi, au sens philosophique, c’est faire sujet. Il y a une notion de l’éthique de l’action qui est fondamentale. Dans le monde de la technique, on régresse sur le plan de l’éthique. C’est paradoxal car on parle de mettre de l’éthique dans les machines, « faire de l’éthique par design », si on veut avancer à part égale, il faut aussi renforcer la sensibilité éthique au niveau des humains ».

Isabelle Galy qui travaille sur la question de la confiance, estime « essentiel d’aider les gens à faire la part entre ce qui est de la menace réelle et ce qui est du fantasme et aussi d’essayer d’identifier et de prévenir les conflits potentiels que l’introduction des IA dans les organisations vont développer ». Elle recommande également la vigilance quant aux biais, aux manipulations que l’IA peut induire.

Pour Pascale Maginot, « ce sont des choix de société. Il y a beaucoup de prospective sur les métiers en 2025, quel sera le RH de demain notamment ? Sera-t-on un avatar qui pourra répondre à toutes les questions des salariés qui seront d’ailleurs digitaux ? » Elle s’interroge aussi sur la place du bonheur, la gestion des émotions. « Quelle place laissons-nous à l’humain dans ces pratiques et à la relation humaine sur ces sujets-là ? »

Aude Vinzerich prévoit que de nombreux emplois vont se transformer. S’adressant directement à notre communauté elle ajoute : « tous les métiers qui embarquent de l’empathie, du sens commun, de l’intuition ne vont pas pouvoir être remplacés par des IA, donc tous les métiers d’accompagnement. En revanche il faut prévoir une transformation de ces métiers d’une part parce que les populations que vous allez accompagner vont être au cœur d’un bouleversement de la société en particulier dans les entreprises et en raison des nouveaux outils qui vont venir vous appuyer dans l’accompagnement que vous pourrez en faire ».

Cliquez ici pour visionner la vidéo de la table ronde.

Table ronde 2 : " Comment allier Intelligence Artificielle et Intelligence Emotionnelle ? Regards de jeunes talents et entrepreneurs "

Les intervenants

- Olivier Malafronte : Fondateur de PocketConfidant, un « coach artificiel » sur smartphone, lui-même coach.

- Andres Davila : Psychologue clinicien, co-fondateur et directeur de la recherche de Praditus, une plate-forme d'évaluation et de développement des compétences comportementales.

- Yannig Lavocat : responsable de l’innovation et Digital Learning Manager de Kedge Business School qui intègre l’IA à ses enseignements.

- Clara Dikita : Vice-Présidente de la CNJE (Confédération Nationale des Juniors Entreprises). Etudiante ingénieure en systèmes embarqués ISEP technologiques.

Aurélie Chalbos Coach ICF, animation

Cette table ronde accueille des acteurs de l’intégration de l’IA directement dans l’univers du coaching et de l’enseignement.

Pocket Confidant explique Olivier Malafronte est un outil qui crée « des moments d’auto-réflexion mais qui n’offre ni diagnostic ni conseil ». Pour aller plus loin, c’est le travail du coach, ajoute-t-il.

Andres Davila définit Praditus comme « un outil de médiation », le relais étant pris par un coach. Il insiste sur le fait que cet outil qui intègre de la digitalisation, du « machine learning », des algorithmes n’est cependant pas de l’IA au sens strict du terme.

Dans les deux cas, l’ambition est « d’offrir au plus grand nombre un outil d’auto-positionnement ». Pour Andres Davila, sa plateforme, utilisée par Hertz et Airbus, veut aider « les organisations à aligner le développement des personnes et leur développement stratégique ». Elle peut être un outil additionnel pour les coachs dans un marché compétitif, ajoute-t-il.

Olivier Malafronte s’attache à « éduquer un robot à écouter un individu, à observer la structure sémantique, étudier son comportement langagier et venir lui poser la bonne question au bon moment pour déclencher un peu de prise de recul, de conscience. Si on arrive à faire cela, ce qui est presque le cas, j’aurai réussi ma mission. A partir de là vous les coachs vous ferez tout le reste », lance-t-il au parterre de coachs.

Kedge Business School introduit l’IA dans ses enseignements en soutien avec du « machine learning », ce qui, de fait, repositionne le rôle du professeur. Afin de familiariser les étudiants avec l’IA, elle inclut des éléments de base de l’IA dans ses cours. « Nous préparons nos étudiants aux compétences de demain : apprendre à apprendre, la résolution de problèmes complexes, l’empathie », explique Yannig Lavocat pour lequel « les métiers de l’empathie, du « care » ont un bel avenir et ils doivent se positionner par rapport à l’IA. Pour préserver la valeur de ces métiers, il faut réfléchir à l’accompagnement humain + IA, à la valeur ajoutée de l’IA, de cette expérience augmentée ».

Clara Dikita souligne l’importance d’une « co-construction éthique de l’IA dans ses usages, en particulier en matière de mixité, afin de ne reproduire les biais de nos sociétés ».

Limites et questions

Le langage façonne la manière de penser rappelle Andres Davila. « L’agilité est un des comportements attendus de demain mais celle-ci sera façonnée par les outils. Nous avons donc une grande responsabilité à cet égard ». Clara Dikita met en garde contre « la prédestination, la catégorisation » et prône la vigilance quant « au dosage entre augmentation du potentiel et contrôle de l’évolution sociétale et de l’innovation ». Yannig Lavocat en appelle à « une co-création avec les acteurs de demain », en particulier au niveau européen, en contre poids aux influences américaine et chinoise sur le développement de l’IA. Olivier Malafronte veut pour sa part « accompagner cette révolution, pour le meilleur de l’humain et étendre le coach ».

Impact de l'Intteligence Artificielle sur les métiers de l'accompagnement

Il prédit de plus en plus de travail pour les coachs, dans notre métier d’accompagnants et considère que « le coaching est le futur du learning » qu’il définit comme la capacité « d’apprendre sur soi et d’observer sa pratique. Le rôle du coach ne sera pas changé, il sera augmenté et plus accepté par la société » assure-t-il. Il voit l’IA comme une « opportunité pour les coachs » et nous encourage à « ne pas en avoir peur, à avoir confiance en l’intelligence collective, et à accompagner cette évolution pour nous aider à mieux apprendre de ce qui nous rend humains ».

Clara Dikita qui a travaillé avec un coach ICF dans le cadre du partenariat ICF-CNJE, s‘attache à « la notion d’humain dans un monde baigné par le digital. L’IA ne peut pas remplacer la présence et le cadre du moment réservé pour soi qu’est le coaching ». Face aux enjeux et aux espoirs d’un monde plus humain, elle souhaite contribuer à « créer la société de demain que nous voulons, ensemble dans la transversalité et l’engagement, en réponse aux « aspirations et une promesse générationnelle ».

Andres voit à la fois des opportunités et des menaces. Des opportunités pour accompagner les grandes entreprises dans transformations ». On a les outils mais pas les coachs » constate-t-il. Face au risque d’une « ubérisation du métier de coach », il nous encourage à nous « solidifier, de nous unir afin de faire valider et réglementer le métier de coach afin d’harmoniser et de défendre tarifs et certifications ».

Yannig Lavocat lance un appel vibrant « l’IA est l’affaire de tous. Après cette journée ne pourrez plus dire «je en savais pas ». On doit tous lire sur l’IA, penser à l’IA pour être des acteurs du monde de demain qui nous appartient si on commence tous ensemble. Il ne faut pas que l’IA soit confisquée par les GAFAM, par certaines start-up, par les visions de certains états comme l’ont été internet et les réseaux sociaux. On a besoin de vous pour domestiquer les IA, pour ouvrir les capots et comprendre l’algorithmie.

Cliquez ici pour visionner la vidéo de la table ronde.

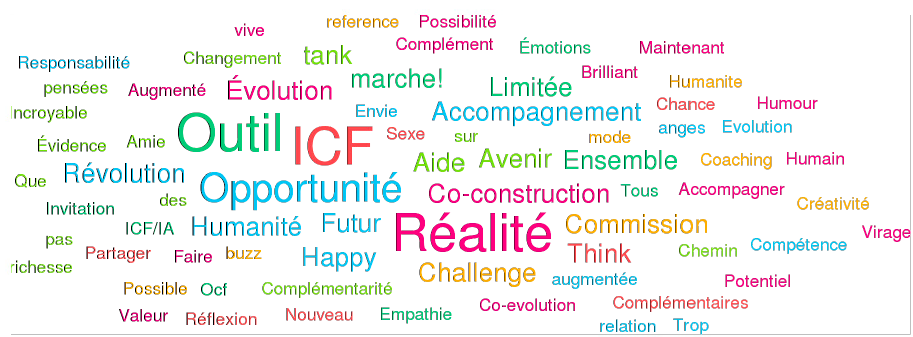

En fin de journée un nouveau nuage de mots sur Klaxoon, indique une attitude moins ambivalente à l’égard de l’IA et une intention de pro-activité.